Tu as vu les videos de robots qui dansent et font des saltos ? Cool, mais jusqu'ici, c'etait du spectacle. En 2026, ca change completement. Tesla, Boston Dynamics et Figure AI lancent tous leurs robots en production de masse — et cette fois, c'est pas juste pour faire le buzz sur YouTube.

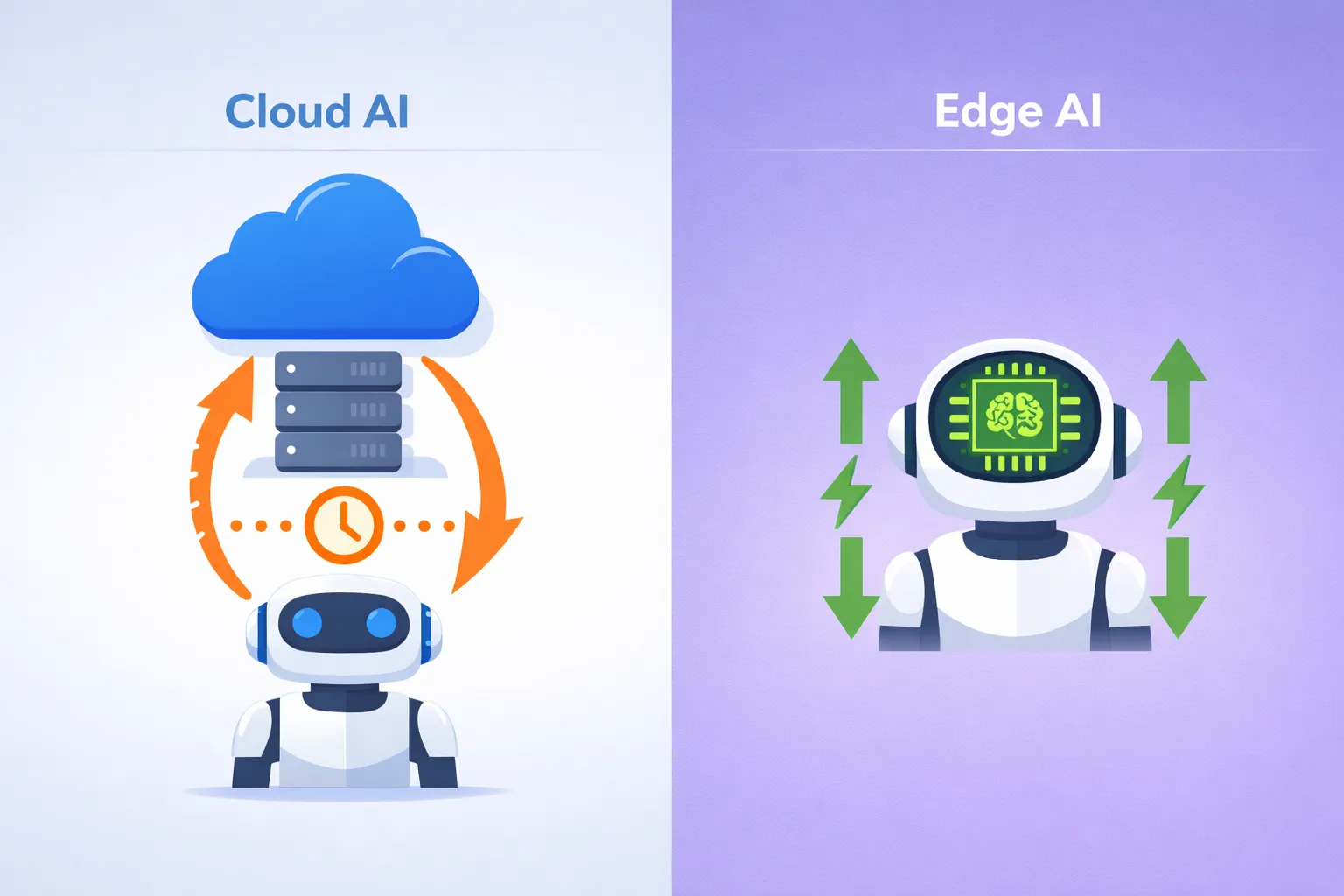

Le truc c'est que l'IA quitte enfin les serveurs cloud pour s'installer directement dans les robots, et ca va bouleverser l'industrie manufacturiere mondiale.

Dans cet article

- Les 6 previsions d'Analog Devices qui vont tout changer

- La course aux robots humanoides : Tesla vs Boston Dynamics vs Figure AI

- Edge AI : quand l'intelligence se rapproche des machines

- Les applications concretes qui arrivent en usine

- Avantages et inconvenients de cette revolution

- FAQ : Tes questions sur la robotique IA

Les 6 previsions d'Analog Devices qui vont tout changer

Franchement, quand Analog Devices — un des leaders mondiaux des semi-conducteurs — publie ses previsions pour 2026, ca vaut le coup d'ecouter. Et spoiler alert : l'IA va enfin sortir de ton ecran pour entrer dans le monde physique.

1. Des robots qui pensent localement

Fini le modele ou le robot envoie ses donnees a un serveur distant, attend la reponse, puis agit. En 2026, les architectures decentralisees permettent aux robots de prendre des decisions en temps reel, sans latence. Comme un humain qui retire sa main d'une surface brulante sans reflechir.

Massimiliano Versace, VP chez Analog Devices, l'explique bien : les robots vont se rapprocher des systemes biologiques, avec des circuits locaux qui gerent les reflexes. Resultat ? Des mouvements plus fluides et une consommation d'energie divisee par 10.

2. Le retour du calcul analogique

Le truc c'est que les processeurs numeriques classiques perdent 80% de leur energie juste a deplacer les donnees. Le calcul analogique fusionne directement capteur et computation. Pour un robot mobile, ca change tout : autonomie de batterie multipliee, reactivite en temps reel.

3. L'intelligence physique

Les modeles IA n'apprendront plus seulement du texte et des images, mais aussi de la vibration, du son, du magnetisme et du mouvement. Imagine un robot en usine qui detecte un probleme mecanique juste en "ecoutant" les vibrations anormales d'une machine.

4. L'audio comme interface dominante

En 2026, tes ecouteurs et lunettes AR deviennent des compagnons context-aware. Pas juste de la reconnaissance vocale basique, mais une vraie comprehension de ton environnement sonore. La Gen Z avec ses hearables "always-in-ear" va adorer.

5. Les agents IA autonomes

L'Agentic AI prend des decisions et agit sans intervention humaine. Paul Golding d'Analog Devices donne un exemple parlant : un agent sur le plancher d'usine qui detecte une machine en train de fatiguer, reroute automatiquement la production vers une machine saine, et coordonne avec la supply chain pour ajuster l'inventaire. Le tout sans qu'un humain touche a quoi que ce soit.

6. Les micro-intelligences specialisees

Des modeles compacts mais ultra-performants dans leur domaine, capables de tourner sur des appareils edge. C'est le chainon manquant entre l'IA programmee rigide et les enormes modeles comme GPT-5.

La course aux robots humanoides : Tesla vs Boston Dynamics vs Figure AI

Game changer : 2026 marque l'annee ou trois geants passent du prototype a la production de masse. Et les chiffres donnent le vertige.

Boston Dynamics : Atlas sort enfin du labo

Le 5 janvier 2026 au CES, Boston Dynamics presente pour la premiere fois son Atlas tout-electrique en public. Hyundai, qui possede l'entreprise, annonce vouloir deployer "des dizaines de milliers" de robots dans ses usines.

La strategie ? La Software-Defined Factory — une usine ou les robots peuvent etre reprogrammes en jours plutot que de reingenieurer la chaine en annees. Contrairement aux convoyeurs figes de l'automatisation traditionnelle, Atlas s'adapte aux changements de production.

Tesla Optimus : l'ambition demesuree

Elon Musk ne fait jamais dans la demi-mesure. Tesla construit actuellement une ligne de production d'un million d'unites pour Optimus. En mai/juin 2026, ils devoileront l'Optimus V3, que Musk decrit ainsi : "Il semblera tellement reel que tu auras besoin de le piquer pour croire que c'est un robot."

La feuille de route long terme ? Optimus V4 a 10 millions d'unites, V5 a 50-100 millions. Tesla a passe une commande de 685 millions de dollars au fournisseur chinois Sanhua pour les actionneurs. C'est du serieux.

Figure AI : les robots qui construisent des robots

Figure AI adopte une approche radicale avec BotQ, une usine ou les robots Figure 03 assemblent... d'autres robots Figure 03. Capacite initiale : 12 000 robots par an, avec un objectif de 100 000 dans quatre ans.

Le principe est simple mais brillant : chaque robot produit augmente la capacite de production. C'est un effet boule de neige. La startup a leve 39 milliards de dollars pour y arriver.

| Entreprise | Robot | Production 2026 | Strategie |

|---|---|---|---|

| Boston Dynamics | Atlas | Dizaines de milliers | Software-Defined Factory |

| Tesla | Optimus | ~180 000 (estime) | Production de masse integree |

| Figure AI | Figure 03 | 12 000 | Robots construisant des robots |

Edge AI : quand l'intelligence se rapproche des machines

Pour etre honnete, la vraie revolution n'est pas le robot lui-meme — c'est l'IA qui tourne dedans. L'Edge AI deplace l'intelligence du cloud vers l'appareil. Et ca change absolument tout.

Le neuromorphic computing explose

Les puces neuromorphiques imitent le fonctionnement du cerveau humain. La ou une puce classique separe memoire et calcul (et perd 80% d'energie en transferts), le neuromorphique fusionne les deux.

Resultat : 80 a 100 fois moins d'energie pour les taches sporadiques (detection d'anomalies, traitement de capteurs). Un capteur de vibration peut fonctionner des mois sur batterie dans une zone isolee. Avec l'architecture classique, il tiendrait quelques jours.

La Commission Europeenne investit massivement, et les analystes prevoient un decollage du marche a partir de 2026.

L'optimisation des modeles

Les techniques de quantization et pruning permettent maintenant de faire tourner des modeles de milliards de parametres sur des appareils edge. SmoothQuant, OmniQuant, SparseGPT... ces noms techniques cachent une realite simple : l'IA puissante n'est plus reservee aux data centers.

Les applications concretes qui arrivent en usine

Maintenance predictive : fini les pannes surprises

Les capteurs integres detectent vibration, temperature et patterns acoustiques pour predire les defaillances avant qu'elles n'arrivent. Schneider Electric rapporte une reduction de 20% du downtime et 15% des couts de maintenance. Une autre etude montre 30% de reduction du downtime imprevu.

FANUC, leader en automatisation, utilise l'inference edge pour un downtime quasi zero non-planifie. Dans l'industrie automobile, chaque minute d'arret coute des milliers d'euros. Tu imagines l'impact.

Controle qualite automatise

Dans la fabrication de PCB, l'IA edge a permis une reduction de 30% du test end-of-line avec une detection de defauts plus rapide. Les systemes vision scannent les anomalies microscopiques en moins d'une seconde et decident : accepter, rejeter ou reinspecter.

L'impact ? Des lignes qui fonctionnent deux fois plus vite que le travail manuel, avec zero defaut livre.

Digital Twins dynamiques

Les jumeaux numeriques ne sont plus juste des maquettes 3D. En 2026, ils deviennent des entites vivantes qui mirrorent les robots physiques en temps reel, apprennent et optimisent continuellement. Les entreprises qui les adoptent a grande echelle verront des ameliorations double-digit de l'OEE (efficacite globale des equipements) d'ici 2027.

Avantages et inconvenients de cette revolution

+ Les Avantages

- Productivite multipliee : 1 robot humanoide equivaut a 5-10 travailleurs humains selon la complexite de la tache

- Downtime elimine : la maintenance predictive supprime les pannes surprises qui coutent des millions

- Flexibilite : contrairement aux lignes d'assemblage figees, les robots s'adaptent aux changements de production

- Efficacite energetique : les puces neuromorphiques consomment jusqu'a 100x moins d'energie

- Securite : les taches dangereuses peuvent etre deleguees aux robots

- Les Inconvenients

- Cout initial eleve : les investissements en robotique et edge AI restent consequents

- Disruption emploi : la transition professionnelle sera brutale pour certains secteurs

- Dependance technologique : une panne systemique peut paralyser toute une chaine de production

- Complexite : l'integration de ces systemes demande des competences pointues

Mon conseil

Ne regarde pas cette revolution de loin en te disant "ca ne me concerne pas". Meme si tu ne travailles pas dans l'industrie, les effets vont se propager partout. Les couts de production vont baisser, les delais de livraison se raccourcir, et de nouveaux metiers vont emerger autour de la maintenance et la programmation de ces systemes.

Si tu bosses dans un domaine susceptible d'etre automatise, c'est maintenant qu'il faut te former aux competences complementaires : supervision de systemes IA, maintenance robotique, analyse de donnees industrielles. Les entreprises qui deploient ces technologies auront besoin de gens pour les piloter — et ces postes seront mieux payes que ceux qu'ils remplacent.

Questions frequentes

Les robots humanoides vont-ils vraiment remplacer les travailleurs humains ?

Pas remplacer, mais transformer les roles. Hyundai parle de "robotic co-workers" plutot que de remplacement. Les taches repetitives et dangereuses seront automatisees, mais la supervision, la maintenance et la programmation creeront de nouveaux emplois. La transition sera difficile pour certains secteurs, mais l'histoire montre que l'automatisation cree plus d'emplois qu'elle n'en detruit — juste pas les memes.

Quand est-ce que ces robots seront vraiment disponibles ?

2026 marque le debut de la production de masse. Boston Dynamics presente Atlas au CES en janvier, Tesla vise la fin 2026 pour demarrer la production Optimus, et Figure AI produit deja 12 000 unites par an. D'ici 2027-2028, on parlera de centaines de milliers de robots deployes dans les usines du monde entier.

L'Edge AI est-elle vraiment plus efficace que le cloud ?

Pour les applications temps reel, oui. Quand un robot doit reagir en millisecondes (eviter un obstacle, ajuster un mouvement), attendre une reponse du cloud est impossible. L'Edge AI offre latence zero, fonctionne sans connexion internet, et consomme beaucoup moins d'energie. Le cloud reste pertinent pour l'entrainement des modeles et l'analyse de donnees massives.

Quels sont les risques de securite ?

Comme tout systeme connecte, les robots IA sont vulnerables aux cyberattaques. Mais l'architecture decentralisee de l'Edge AI reduit ce risque : pas de point central unique a pirater. Les fabricants integrent aussi des mecanismes de securite materielle dans les puces neuromorphiques.

Conclusion

2026 n'est pas juste une annee de plus dans l'evolution de l'IA — c'est le moment ou la technologie quitte definitivement les ecrans pour s'incarner dans le monde physique. Tesla avec son million d'Optimus, Boston Dynamics avec Atlas au CES, Figure AI avec ses robots qui s'auto-repliquent... les pieces du puzzle s'assemblent.

Le duo robotique + IA decentralisee redefinit ce que signifie "fabriquer" quelque chose. Des usines qui s'auto-optimisent, des machines qui predisent leurs propres pannes, des robots qui apprennent en temps reel de leur environnement. C'est pas de la science-fiction, c'est janvier prochain.

Tu veux comprendre comment l'IA transforme concretement le monde du travail ? Decouvre nos autres analyses sur les Actualites IA.

A propos de l'auteur : Flavien Hue teste et analyse les outils d'intelligence artificielle depuis 2023. Sa mission : democratiser l'IA en proposant des guides pratiques et honnetes, sans jargon technique inutile.